PR-Blog

Fake-Erfolge in der Pressearbeit

Manche Dienstleister für PR-Schaffende sind recht einfallsreich, um ihre „Dienstleistung“ an das Unternehmen zu bringen. Das Ziel: unerfahrenen Marketingverantwortlichen und Geschäftsführern Presseerfolge zu suggerieren, wo keine sind.

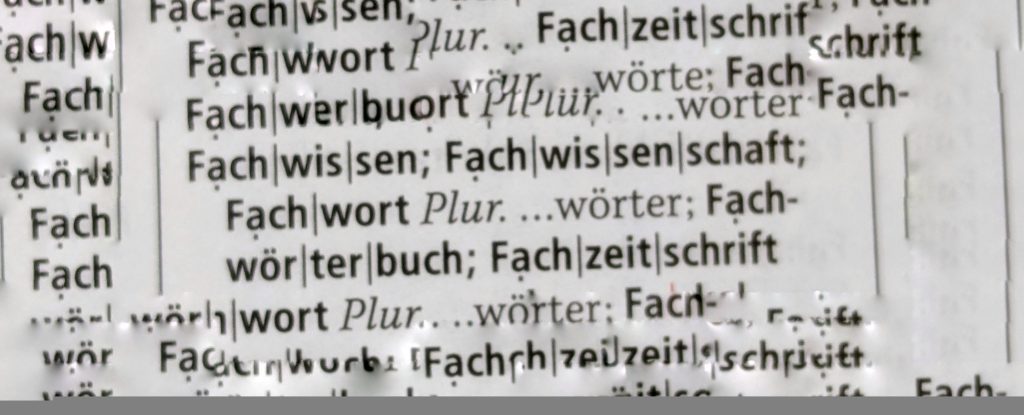

Floskeln

Woher kommen die inhaltsleeren Sprachschnipsel, die wir als Füllwörter und Floskeln bezeichnen, in unserem Sprachgebrauch?

Die TikTok-Taktik

Letzte Woche fand vor dem US-Kongress eine Anhörung zu chinesischer Spionage und Einflussnahme via TikTok statt. TikTok kämpft darum, in den USA nicht verboten zu werden.

Mehr Ehrlichkeit in der Kommunikation wagen

Die Vorteile von mehr Ehrlichkeit in der Kommunikation. Ja, es gibt sie.

Presseerfolge nach innen kommunizieren

Wie kommuniziert man eigentlich Presseerfolge nach innen? Und was bringt das?

Make the Journalist WOW!

Es gibt Dinge, die ohne Worte funktionieren. Gute Interviews gehören sicher nicht dazu.

Unter der Lupe: zeitnah

Heute nehmen wir einen Begriff unter die Lupe, der vor etwa 20 Jahren in Politikerkreisen auftauchte und seitdem unaufhaltsam Karriere macht: zeitnah.